De continuar con el proceso evolutivo, una máquina podría alcanzar niveles de inteligencia inaccesibles para los seres humanos en poco tiempo.

Por Manuel Godoy

“No deberíamos confiar en nuestra capacidad para mantener encerrado a un genio súper inteligente de manera indefinida.”

Nick Bostrom

En el artículo anterior se describió el impacto que tendrán los inminentes avances en Machine Learning sobre el mercado laboral y la sociedad en general. Estos avances están asegurados de acuerdo a los expertos, y el único factor de incertidumbre es cómo reaccionará la sociedad.

Sin embargo, una vez que la Inteligencia Artificial (IA) llegue a cubrir la mayoría de las tareas especializadas que contribuyen a la productividad económica, ésta podría seguir evolucionando hasta convertirse en la inteligencia más desarrollada del planeta, desplazando al ser humano.

A diferencia de los artículos anteriores, en esta sección final entramos en un terreno altamente especulativo. Previamente hemos comentado que no hay avances tangibles que nos permitan proyectar con certeza cuándo tendremos inteligencias equiparables o superiores a la humana; sin embargo, muchos expertos estiman que esto ocurrirá durante el siglo XXI.

Las proyecciones más optimistas se encuentran en el rango de los años 2030 a 2060. Otros, sin embargo, creen que replicar el nivel de inteligencia de los seres humanos, el cual surgió a partir de un proceso de cientos de millones de años de evolución, está fuera de nuestro alcance.

Para dar una mejor perspectiva respecto a los artículos previos, podemos dividir las capacidades de la IA en tres categorías:

1. Inteligencia Artificial Específica: Este es el tipo de IA que ya se ha materializado. Cada vez que escuchamos que una máquina ha derrotado a una persona en alguna tarea específica (ajedrez, diagnóstico médico) es porque un algoritmo de Machine Learning, construido a base de redes neuronales, y alimentado con la suficiente cantidad de datos, ha podido igualar o superar los resultados que una persona hubiera obtenido por sí misma.

2. Inteligencia Artificial General: Se refiere a una computadora cuya inteligencia es equiparable a la inteligencia humana, más allá de aquellas tareas que el Machine Learning ya ha logrado dominar. De acuerdo a la profesora Linda Gottfredson, este nivel de inteligencia implica “razonar, planear, resolver problemas, pensar de manera abstracta, comprender ideas complejas, aprender rápidamente y aprender con base en la experiencia”.

3. Súper Inteligencia Artificial: Nick Bostrom, filósofo y experto en IA, define este nivel de inteligencia como “un intelecto que es mucho más inteligente que los mejores cerebros humanos en prácticamente cualquier campo, incluyendo creatividad científica, sabiduría en general, y habilidades sociales”.

La Inteligencia Artificial Específica es una realidad, impulsada por los algoritmos de Machine Learning y Deep Learning, así como por las capacidades actuales de recolección de datos. Sin embargo, aún no se tiene una ruta clara hacia la obtención de la Inteligencia Artificial General (IAG), la cual implica dominar una amplia variedad de entornos.

Una máquina puede ser entrenada bajo parámetros muy específicos, pero carece de la capacidad de comprender la realidad al nivel de detalle que lo hacemos los seres humanos, en términos de ideas, objetos, categorías, o incluso conceptos como el sentido del humor o la ironía.

El escritor Tim Urban sugiere dos claves para el desarrollo de la Inteligencia (IAG):

- Mayor capacidad de procesamiento: Considerando el total de componentes del cerebro humano, el futurólogo Ray Kurzweill, apoyado con varios estimados de expertos, estima que su capacidad de procesamiento es de 1016, es decir, 10 cuatrillones de cálculos por segundo. Esta capacidad de procesamiento ya está al alcance de las mayores supercomputadoras. Se estima que antes que termine la década de 2020 esta capacidad de procesamiento será accesible a un costo de $1,000 USD.

- Desarrollar verdadera inteligencia: Tim Urban explica que si el cerebro de un chimpancé repentinamente se vuelve 1000 veces más rápido, seguirá careciendo de aquellas interconexiones o módulos que hacen posible el razonamiento abstracto o las capacidades lingüísticas complejas. Al día de hoy desconocemos exactamente cómo funciona el cerebro humano y seguimos a la espera de la “gran idea” que permita aprovechar el poder computacional disponible para lograr que una máquina pueda adquirir verdadera inteligencia más allá de las capacidades de Machine Learning, que son efectivas en entornos muy específicos.

Entre las estrategias más comunes para aproximarnos a la IAG destacan las siguientes:

- Replicar el funcionamiento del cerebro humano: Mediante escaneos y análisis, buscar aplicar un proceso de ingeniería inversa para comprender el funcionamiento de nuestros cerebros, y aplicarlo a una máquina.

- Replicar el proceso de evolución: El método de algoritmos genéticos permite replicar el proceso de selección natural identificado por Darwin. Un grupo de algoritmos tendría asignadas diversas tareas asociadas a la Inteligencia Artificial General, de tal manera que los algoritmos más exitosos podrán recombinarse con otros algoritmos exitosos. Este proceso también se asemeja a la selección artificial que dio origen a numerosas especies domésticas (gatos, perros) o a frutas y legumbres comestibles.

- Generar un programa experto en IA que pueda efectuar cambios sobre sí mismo: Esta estrategia depende más de la inventiva humana que las anteriores. En vez de buscar replicar un proceso (evolución) o un producto (el cerebro humano), la idea es diseñar una computadora altamente especializada en IA que pueda evaluarse a sí misma e implementar sobre sí misma los cambios necesarios para volverse más inteligente.

Alguna de estas estrategias -o alguna aún no imaginada- combinada con un alto poder de procesamiento maquinal, podría originar un sistema autónomo capaz de “pensar” de manera similar a los seres humanos. Esta es una posibilidad real, reconocida por la mayoría de los expertos en IA.

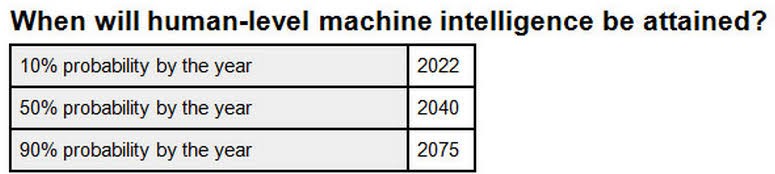

Nick Bostrom, filósofo de la Universidad de Oxford y un referente en el tema de IA, buscó consolidar la opinión de los expertos con base en diferentes encuestas disponibles. La mayoría cree que las máquinas podrían tener una inteligencia equiparable o superior a la inteligencia humana durante el siglo XXI. Por su parte, Bostrom publicó su estimado en 2014, en su libro Superintelligence: Paths, Dangers, Strategies, cuando el 2022 estaba todavía a 8 años de distancia.

Es importante notar que este tipo de avances -una vez que las barreras iniciales son superadas- progresan de manera exponencial. Una máquina que pueda emular primero la inteligencia de un mosquito, después la de un ratón, de un chimpancé y luego de un humano no necesariamente se detendría en ese punto. De continuar con el proceso evolutivo, dicha máquina podría alcanzar niveles de inteligencia inaccesibles para los seres humanos en poco tiempo.

Esto no debería resultar tan sorprendente. El cerebro humano es un producto de la evolución, la cual premia la supervivencia, y no necesariamente la inteligencia. Bajo otro tipo de condiciones hubiera sido posible que otra especie -con mayor capacidad cerebral- se hubiera convertido en la especie dominante del planeta. Quizá ahora en el siglo XXI los seres humanos estamos creando este tipo de condiciones.

La Inteligencia Artificial no te odia, ni te ama, pero estás hecho(a) de átomos que puede usar para otra cosa.

Eliezer Yudkowsky

Para entender mejor la preocupación de muchos expertos, es necesario tomar en cuenta las siguientes circunstancias:

- La IAG podría llegar pronto: Por los motivos explicados, quizá nos hace falta una sola “gran idea” para detonar el surgimiento de la IAG. La historia nos dice que es imposible predecir con exactitud este tipo de ideas, pero una vez que surgen, como la Teoría de la Relatividad de Einstein o el Modelo Heliocéntrico de Copérnico, dejan su huella de manera permanente en la sociedad.

- La IAG/Superinteligencia podría ser impredecible: No hay manera de anticipar el comportamiento que tendrá una Súper Inteligencia, o incluso una inteligencia equiparable a la humana y que además tenga la ventaja de poder acceder al Internet, generar copias de sí misma, y cualquier otra capacidad digital imaginable. Si contáramos con un conocimiento detallado del funcionamiento del del cerebro, entonces quizá -y solo quizá- podríamos aspirar a implantar una especie de “seguro” en nuestra hipotética creación inteligente. Pero todo parece indicar que el camino a la IAG será a través de varios ciclos iterativos, con un resultado final mucho más complejo que nuestro viejo conocido Watson.

- La IAG/Superinteligencia excederá nuestra comprensión: Así como un chimpancé carece de las capacidades abstractas que tiene un ser humano, no hay manera de conocer cuales serían las capacidades de una máquina con Súper Inteligencia Artificial. El nivel de inteligencia humana es producto de millones de años de evolución, que se estabilizó con la especie Homo Sapiens, y no necesariamente es un tope imposible de superar. Una vez que este nivel de inteligencia cobre existencia, posiblemente el superarla, derrotarla o neutralizarla estaría fuera de nuestro alcance.

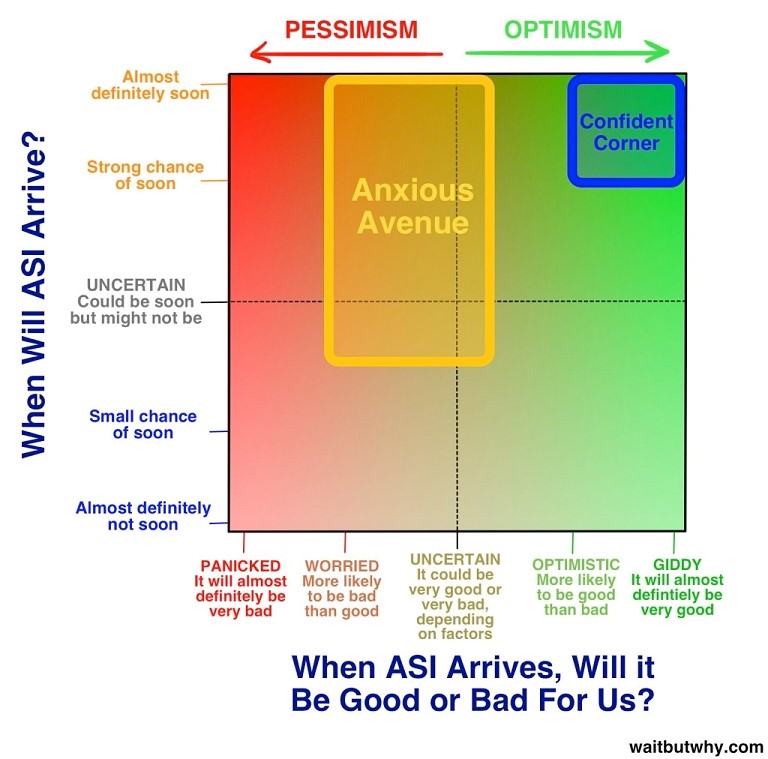

Tim Urban agrupa las opiniones preponderantes de los expertos en Inteligencia Artificial en dos grupos: los optimistas, que visualizan un futuro brillante en las próximas décadas; y los ansiosos, que creen que hay un alto riesgo de que las consecuencias sean negativas. Son muy pocos aquellos que aseguran que la IAG está todavía a uno o varios siglos de distancia, o que nunca ocurrirá.

Al día de hoy ya hay investigación técnica que busca contener las consecuencias no deseadas de una Súper Inteligencia Artificial, buscando dotarla de comportamientos de cooperación, entornos seguros y una adecuada estimación de riesgos. Universidades como Oxford y Stanford, así como empresas como Open AI de Elon Musk y Google Deepmind lideran estos esfuerzos.

No obstante, la mayoría de la atención está enfocada en nuevas aplicaciones del Machine Learning y la búsqueda de la “gran idea” para detonar la IAG, la cual podría conducir inmediatamente a la Súper Inteligencia Artificial. Voces como Stephen Hawking o el mismo Elon Musk han advertido del enorme riesgo que ésta representa. Es tiempo de prestar más atención.

One comment

Jose

19/11/2020 at 23:58

Es el mejor artículo que leído de punta a punta. El mejor contenido online, grandes redactores. Felicidades. 🙂